화상·영상을 입체로 변환하는 기술 'Neural Radiance Fields(NeRF)'로 카메라가 이동하면서 촬영한 긴 영상을 취급하는 것은 어렵고 품질에 어려움이 있었는데, 최근 한국과학기술원과 국립대만대학, Meta, 메릴랜드대학교 컬리지파크교의 연구자들이 긴 영상에서도 고품질의 3D 데이터를 렌더링할 수 있는 기법을 고안해냈습니다.

Progressively Optimized Local Radiance Fields for Robust View Synthesis

https://localrf.github.io/

Immersive 3D Rendering from Casual Videos? - YouTube

https://www.youtube.com/watch?v=VizL7q9o-5Y

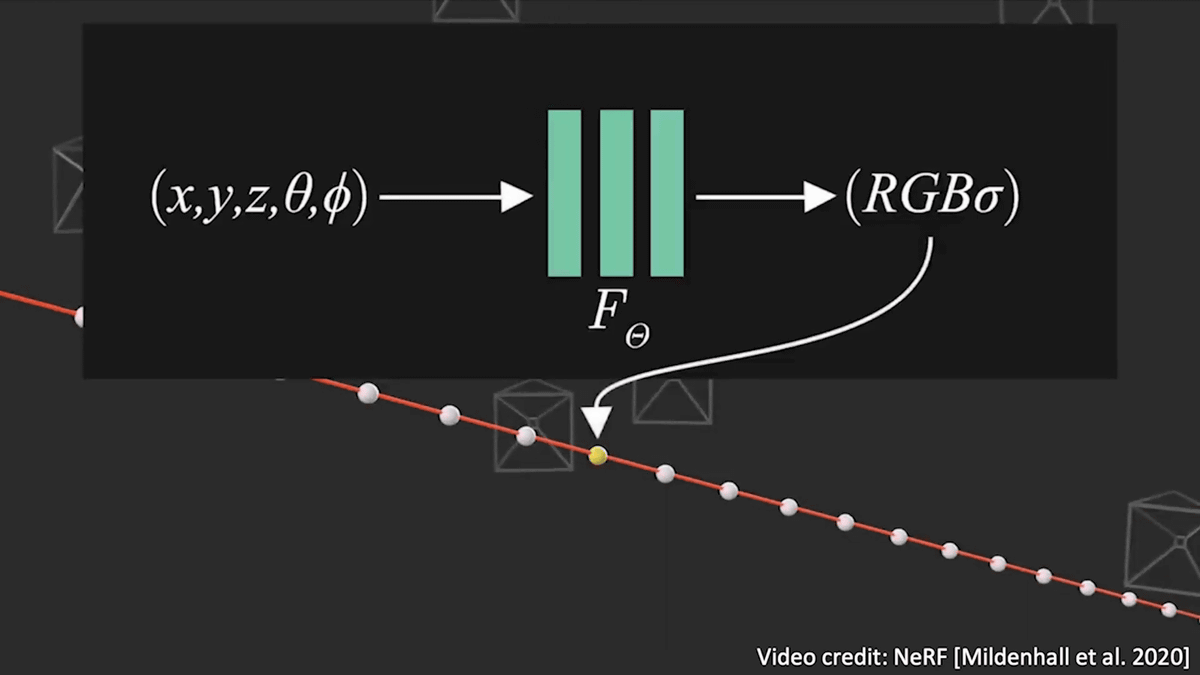

화상·영상을 입체로 변환하는 기술 'Neural Radiance Fields(NeRF)'는 3차원의 위치정보와 시야의 방향을 밀도나 색에 대응시켜 볼륨표현을 최적화하고 있습니다.

그런 다음 볼륨 렌더링을 사용하여 픽셀을 렌더링할 수 있습니다. 이 렌더링 프로세스는 미분 가능하며 모든 광선을 렌더링하여 재구성 오류를 최소화하여 장면표현을 최적화할 수 있습니다.

합성 오브젝트라면 유계영역에서 쉽게 표현할 수 있기 때문에 이 방법이 매우 유효합니다.

현실 풍경의 경우 카메라에 가까운 물체와 먼 물체도 포함되기 때문에 조금 어려워집니다. 모든 카메라가 같은 방향을 향하고 있는 경우는 정규화 디바이스 좌표(NDC)를 사용해 공간을 변형시켜 경계를 설정할 수 있습니다.

카메라가 안쪽을 향한 360도 사진의 경우 'Mip-NeRF 360'이 공간을 유계영역에 매끄럽게 변형시키기 위한 수축조작을 제공해 줍니다.

그러나 어려운 것은 긴 궤적에서 캡처된 대규모 장면의 모델링입니다. 수축기술은 여전히 적용 가능합니다.

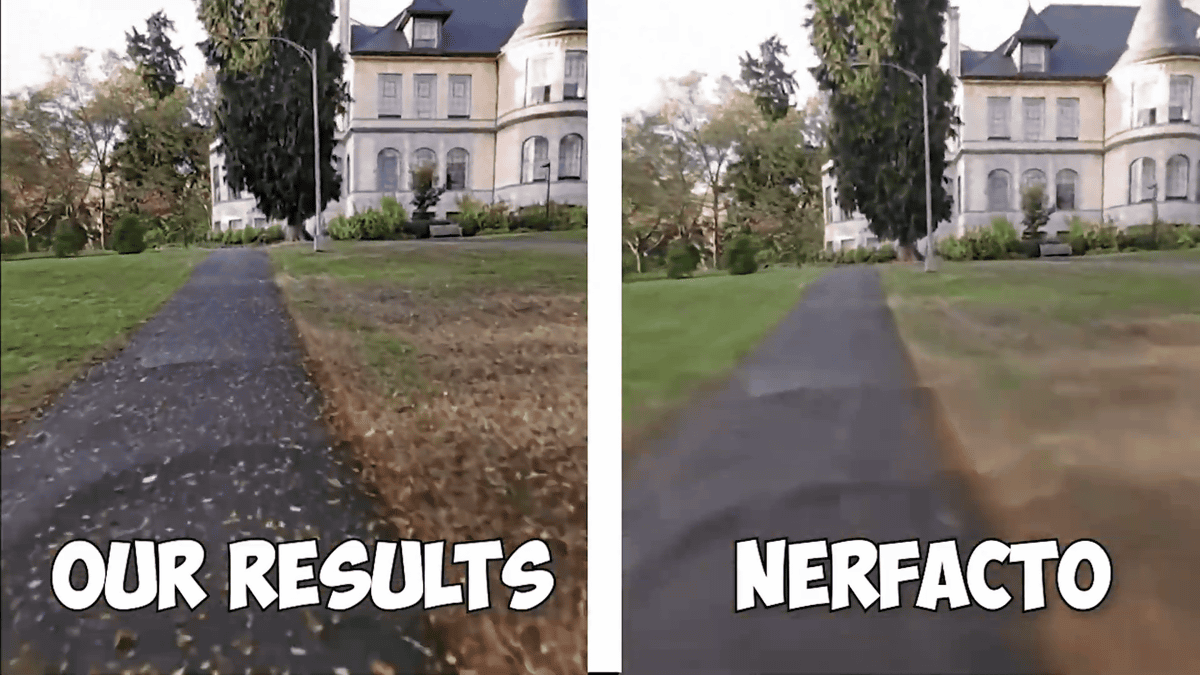

렌더링 결과는 처음에는 좋은 것처럼 보였지만 중심에서 멀어질수록 품질이 떨어집니다. 그래서 연구팀이 생각한 것은 궤적을 따라 여러 국소적인 방사휘도 필드를 만드는 방법입니다. 이를 통해 고품질의 재구성 및 자유시점 합성결과를 유지하면서 매우 긴 시퀀스를 처리할 수 있습니다.

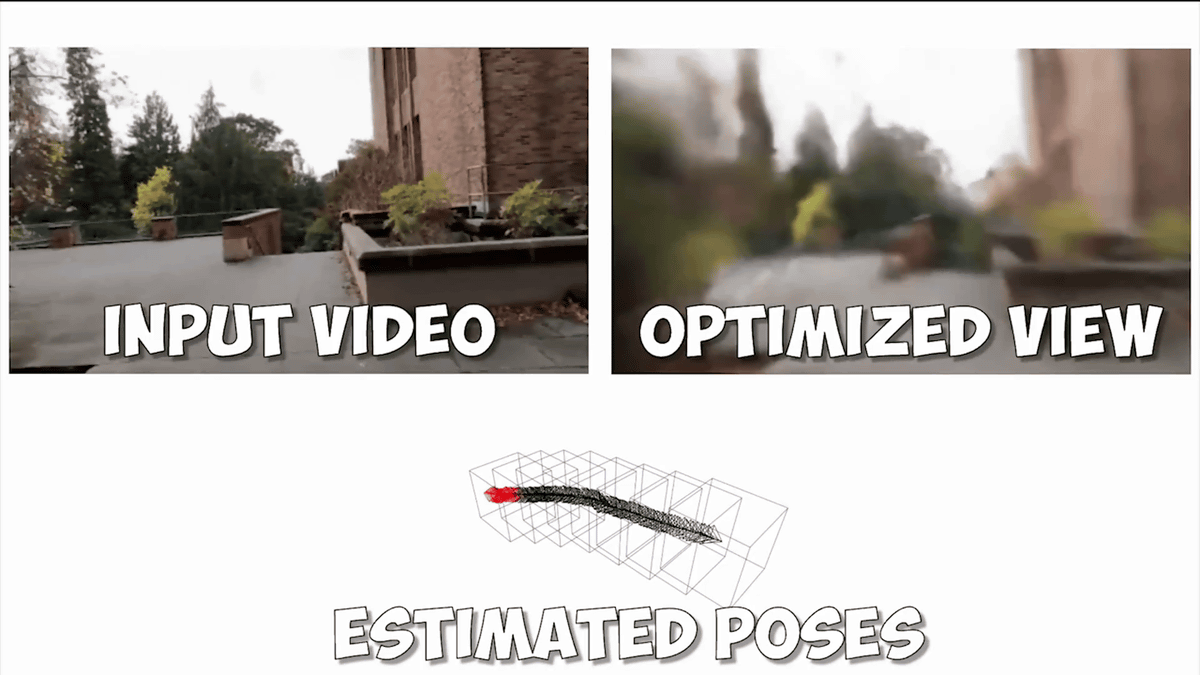

남은 과제는 카메라의 구도입니다.

대부분의 NeRF는 SfM(Structure from Motion) 알고리즘을 통해 카메라 구성을 확실하게 추정할 수 있다고 가정합니다. 그러나 SfM 알고리즘은 견고하지 않은 경우가 많으며, 구도추정에 실패하면 해결책이 없습니다.

그래서 생각한 것이 방사휘도 필드와 함께 카메라 프로세스를 예측하는 수법. 이 수법은 짧은 시퀀스이면 잘 작동하지만 긴 시퀀스라면 작동하지 않습니다.

그래서 연구팀은 국소적인 방사휘도 필드를 만드는 틀로 카메라 프로세스를 점진적으로 추정하기로 했습니다. 국소적 추정과 점진적인 추정을 통해 더 높은 견고성을 제공하게 되었습니다. 렌더링은 인접한 방사휘도 필드의 결과를 혼합하여 원활한 전환을 실현합니다.

영상 후반부에서는 다른 NeRF와의 비교가 이루어졌으며 연구팀의 기술이 긴 시퀀스에서도 매끄러운 렌더링에 성공하고 있음을 알 수 있습니다.

'IT' 카테고리의 다른 글

| 스마트폰을 체온계로 활용할 수 있는 앱 'FeverPhone' (0) | 2023.06.23 |

|---|---|

| Apple Watch가 수면 중 폐혈전을 경고 (0) | 2023.06.21 |

| Google 대책의 SEO로 만들어지는 검색로봇용 블로그 기사 (0) | 2023.06.21 |

| VPN 앱 'Swing VPN'이 이용자를 몰래 DDoS 공격에 가담시켜 (0) | 2023.06.20 |

| 인텔이 12양자비트 양자컴퓨터 칩 'Tunnel Fall'을 발표 (0) | 2023.06.16 |

| 장치의 전원 LED를 비디오 촬영하여 암호화 키를 훔치는 방법 (0) | 2023.06.15 |

| 무료로 GPT-4를 이용하고 요금을 타인에게 지불하게 하는 '해적판 GPT-4'가 횡행 (0) | 2023.06.09 |

| 월 280만 원 상당의 기본소득을 영국이 2년간 시험도입 (0) | 2023.06.08 |